百度蜘蛛程序工作原理与配额优化策略

诺丁科技2023-12-150

“百度蜘蛛即是百度搜索引擎蜘蛛程序的简称,是搜索引擎负责抓取网络信息的一个自动程序。那么百度蜘蛛是以什么样的抓取策略,访问爬行互联网中的网页、图片以及视频等内容,百度蜘蛛为网页建立索引数据库的工作原理和流程是什么?”

日益增长且杂乱无章的互联网信息,和大型图书馆一样需要进行整理并建立索引目录,而搜索引擎就是通过网络爬虫程序不断抓取并建立信息索引,因其工作原理也被形象的称之为蜘蛛程序,百度蜘蛛(Baidu Spider)就是对百度搜索引擎爬虫程序的一种统称。

如果将互联网比作是一张蜘蛛网,那么搜索引擎爬虫程序就是不断爬行的蜘蛛,并根据超链接地址访问爬行抓取目标页面内容,不断地将当前页面中新出现的超链接,作为下一轮爬行抓取的目标链接,从而实现对互联网网页信息的遍历抓取。

搜索引擎蜘蛛不仅要发现抓取新网页完成收录索引,同时还要对已经索引建库的网页进行更新,因此面对全网上千亿的网页链接,百度蜘蛛程序不断的重复着爬行抓取、分容收录分析以及建库索引的步骤,并对收录分析过滤后对有意义和价值的页面做建库索引处理。

百度蜘蛛工作原理及流程(搜索引擎信息处理流程)

1、爬行抓取

百度蜘蛛会从已建库索引的链接爬行抓取,收录量索引量越高的网站蜘蛛资源也就越多。另外百度蜘蛛还需要尽快完成新内容的收录,对于网站内容更新频率与频次越高的站点也会有较大的抓取配额。因此在内容质量价值越高的基础上去提升网站更新频率,那么自然会得到足够的蜘蛛抓取配额资源,达到新内容产出的秒收录效果。

2、收录分析(内容过滤)

无论是已建库索引还是新产出的网页内容,搜索引擎需要对有用的内容进行筛选识别,尤其是低质无效的链接和网页,既不利于用户的搜索体验,同时也会导致优质站点权益受损,因此无论是对建库索引还是新产出内容都要进行分析过滤。

3、建库索引

通过蜘蛛的爬行收录分析,百度对优质内容进行建库索引,而有效索引或高质量索引才会作为搜索结果呈现给用户。当用户进行关键词搜索的时候,搜索引擎会根据一系列的算法和规则匹配索引库里的内容,并以动态变化的排序展现给搜索用户去选择。

百度蜘蛛抓取配额优化策略

对于整站SEO优化而言建库索引是目的,而引导蜘蛛爬行抓取是提升收录索引效率的关键,因此在内容质量的基础上如何提升网站蜘蛛配额,并将既定的蜘蛛抓取资源优先分配给最有价值的网页,才是整站SEO系统化思考和需要解决的问题所在。

百度蜘蛛对已做建库索引处理的网页内容,需要定期抓取爬行进行更新检测,同时也会作为发现抓取新产出网页内容的种子链接。因此如何让网站新内容在最短的时间内被蜘蛛爬行,就是SEO优化的首要问题,否则内容质量再高的页面不被百度蜘蛛抓取,就不会有收录索引的可能更不会获取关键词排名。

在百度搜索资源推出收录工具之前,外链发布便是最佳的SEO实践方式,甚至衍生出了蜘蛛池这种加快蜘蛛爬行抓取链接的SEO工具,而百度官方推出收录工具让站长主动推送内容资源缩短爬虫发现网站链接的时间,即解决了优质站点内容链接被发现的时间,又在一定程度上鼓励引导了SEO优质内容的产出。

搜索引擎对不同规模与质量的站点分配的蜘蛛资源相对固定,因此面对有限的蜘蛛抓取配额,整站SEO优化还需要通过内链结构优化以及nofollow设置,更好的引导百度蜘蛛优先爬行抓取重要网页,比如搜索价值较高或新产出的内容链接。

尽管Baiduspider爬行抓取也是一种站点访问行为,但并不会造成网站带宽堵塞影响正常用户访问,百度蜘蛛会根据服务器的负载能力自动调节抓取频次与时段,当然站长也可以通过百度搜索资源平台进行抓取频次上限设置。

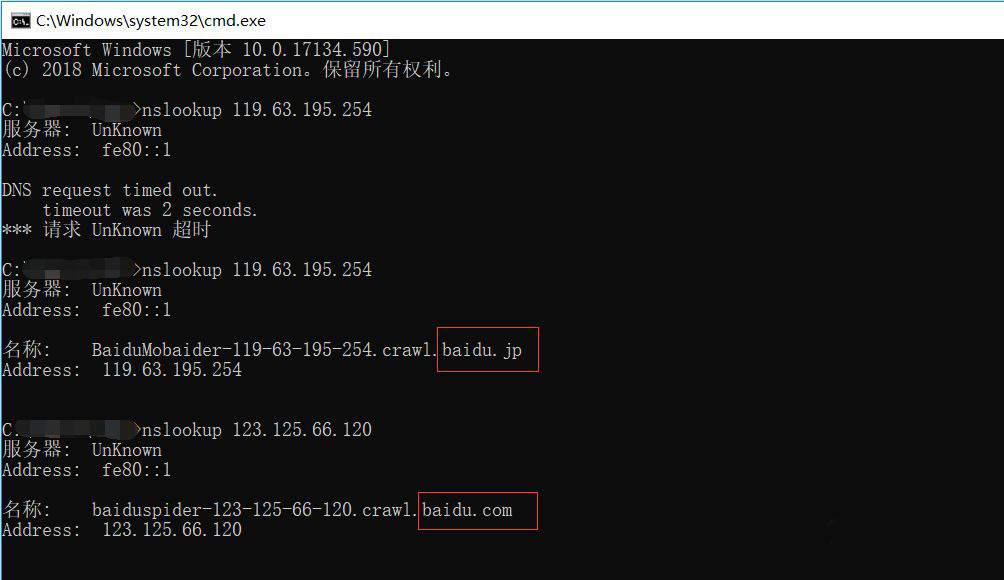

如果在网站访问日志分析中发现与百度官方统计的抓取频次数据出入较大,很有可能是人为冒充Baiduspider的恶意抓取,建议站长通过DNS反查IP的方式判断是否伪造百度蜘蛛UA后选择适当的反制措施,既减少了网站服务器与带宽的负荷,同时也避免了网站被恶意抓取采集的风险